统计推断这门学科主要关注如何从随机过程产生的数据中提取信息,它是流程、方法和理论的统一。 **统计推断 需要新的点子,将这些采集到的数据进行简化,使它们更易于理解,能够以一种更简明扼要的方式概述世界运行的规律,能够易于使用数学对其进行建模的数据,这称为统计估计量。 这一套从现实世界到数据,再由数据到现实世界的流程就是统计推断的领域。 更准确地说,统计推断这门学科主要关注如何从随机过程产生的数据中提取信息,它是流程、方法和理论的统一。

总体和样本

在经典统计学理论中,有总体和样本之分。在统计推断中,总体并不特指人口,它指的是一 组特定的对象或单位,比如推特上发布的消息,照片或者天上的星星等。如果我们可以度量和提取这些对象的某些特征,就称为对总体的一组观察数据,习惯上,使用N表示对总体的观察次数。 所谓样本,是指在总体中选取的一个子集,用n来表示。研究者记录下样本的观察数据,根据样本特征推断总体的情况。采样的方法多种多样,有些采样方法会存在偏差,使得样本失真,而不能被视为一个缩小版的总体,去推断总体的特征。当这种情况发生时,基于样本分析所推断出来的结论常常是失真甚或完全错误的。

大数据的总体和样本

采样可以解决一些工程上的挑战:使用多少数据取决于你的目标:比如,做分析或推断,你只需要部分的数据就可以了;但当你试图在用户界面上展示其中一个使用者的信息时,你可能需要搜集该使用者的所有数据。 偏差:如果你不了解相关的语境或者一无所知,你就不可能对数据做出合理的解释。 采样:在统计学中,我们通常使用一种基础的数学方法来建模,描述总体和样本 的关系。针对背后可能存在的规律、数学结构以及生成数据的过程,我们会做出一些简单假设。每一次研究,我们对其中一种数据生成过程中所采集到的数据进行观察,这组数据就是所谓的样本。 由于采样过程不同所带来的不确定性有一个学名:取样分布。 新的数据类型要求我们在做采样时需更谨慎。 大数据中的4V原则。这4V是指容量(Volume)、种类(Variety)、速度(Velocity)和价值(Value)。

大数据意味着大胆的假设

忽视因果关系是大数据法则的一种缺陷,而不是特征。忽视因果关系的模型无助于解决现存问题,而只会增加更多问题。数据也不会自己说话,它只能够以一种量化的、无力的方式去描述、再现我们身边的社会事件。

建模

人类试图用各种方式去描述他们所处的世界。统计学家和数据科学家则用函数表示产生数据的过程中存在的不确定性和随机性,并以此来形容数据本身的样貌和结构。 模型是人工设计的,用于将无关紧要的细节排除或抽象化。在进行模型分析时,研究者必须关注这些被省略的细节。 统计建模 在引入数据和开始编写代码前,对于建模的流程有一个大概的了解是有益的。先干什么?谁受谁的影响?什么是因,什么是果?检验结果如何?这些都是我们应该思考的问题。 如何构建模型 探索性数据分析(EDA)是一个好的开始。它牵扯到绘制图形和从数据集中获取直观的感觉。与试错、反复实验一样,探索性数据分析对问题的解决大有帮助。 举例来说,你可以(或者说是应该)先绘制直方图或散点图以对数据产生一个直观的感受,然后试着写点什么,哪怕一开始是错误的(很可能一开始的结论是错误的,没关系)。 比如写出来的是一个线性方程,当你把它写下来,就会强迫自己去思考:这个方程有意义吗?如果没有,为什么没有?那怎样的方程对这个数据集是有意义的?你从最简单的方式开始,逐渐增加复杂度,做出假设并把你的假设写下来。如果你觉得完整的陈述有帮助,就把句子 写完整,比如:“我假设将用户自然分成五组,因为销售代表谈起用户的时候,她把用户分成了五类。”然后试着用方程式和代码来表达这一陈述。 记着,从简单处着手永远是个好办法,建模时在简单和准确之间有一个权衡。简单的模型易于理解,很多时候,原始简单的模型帮你完成了90%的任务,而且构建该模型只需要几个小时,采用复杂的模型或许会花上几个月,而且只将这个数值提到了92%。 概率分布 概率分布是统计模型的基础。 回到还没有发明计算机的年代,科学家观察到了现实生活中的一些现象,经过测量后发现,一些固定的数学模式在重复出现。 自然状态下产生的数据,可以用数学函数来描述。通过设定函数中的参数,可使函数曲线接近于实际数据的分布形态。而这些参数可在对数据进行估计的基础上得出。 不是所有过程产生的数据都服从某种已知的分布,但很多都服从。我们可以应用这些分布函数作为模块,来构建最终的模型。 概率分布可以理解为对于可能结果的子集指定一个概率,概率分布用与其对应的函数来表示。 假设随机变量x的概率分布为,该函数将x映射为一个实数,要使其成为概率密度函数,需要对其做以下限定:使用积分求曲线覆盖下的面积,则其值必须为1,这样才能称其为概率。 怎么知道该使用哪种概率分布?有两种方法:首先,可以做实验。 使用单变量函数可以描述一个随机变量的分布,描述多个随机变量则需要使用多变量函数,这称作联合分布。以两个随机变量为例,使用函数表示概率分布,输入为平面上的点,输出为一个非负数。为了确保其是一个概率分布函数,在整个平面求二重积分,其值为1。 还有一种分布叫条件分布,其含义是当y给定时x的概率密度函数。 处理数据时,条件意味着一个子集。 拟合模型 拟合模型是指用观察数据估计模型参数的过程。以数据为依据,近似模拟现实中产生数据的数学过程。拟合模型经常要引入各种优化方法和算法,例如最大似然估计等,来确定参数。 事实上,当你估计参数时,参数就成了估计量,他们本身就是数据的函数。当模型拟合成功,就能以数学函数的形式表达。 过拟合 过拟合是指使用数据去估计模型的参数时,得到的模型并不能模拟现实情况,在样本以外的数据上效果不好。 在试图用该模型去预测另一组数据(该组数据未用来拟合模型)的标签时,你可能会发现结果不尽如人意,以准确度去衡量,这并不是一个很好的模型。

探索性数据分析

探索性数据分析是建模的第一步。探索性数据分析经常表现为画一些直方图或者茎叶图。 验证性数据分析偏重于模型和假设。在探索性数据分析中,没有假设,也没有模型。这里的“探索性”是指你对待解问题的理解会随着研究的深入不断变化的。 探索性数据分析的基本工具是图、表和汇总统计量。一般来说,探索性数据分析是一种系统性分析数据的方法,它展示了所有变量的分布情况(利用盒形图)、时间序列数据和变换变量,利用散点矩阵图展示了变量两两之间的关系,并且得到了所有的汇总统计量。换句话说,就是要计算均值、最小值、最大值、上下四分位数和确定异常值。 探索性数据分析不仅是一组工具,更是一种思维方式:要怎么看待和数据之间的关系。你想理解数据,了解数据的形状,获得对数据的直观感受,想将数据和你对产生数据的过程的理解关联起来。探索性数据分析是你和数据之间的桥梁,它不向任何人证明什么。

使用探索性数据分析有很多重要的原因。包括获取对数据的直觉、比较变量的分布、对数据进行检查(确保数据的规模在你预期范围内,数据的格式是你想要的等)、发现数据中的缺失值和异常值、对数据进行总结。探索性数据分析确保了产品的性能符合预期。 在探索性数据分析中会引入许多图形。探索性数据分析是数据分析的开端,而数据可视化是在数据分析的最后一个环节,用于呈现数据分析的结论。在探索性数据分析中,图形只是帮助你理解数据。 在处理数据时,若没有将探索性数据分析视为重要一环纳入到整个研究过程中,这对研究结果极为不利。

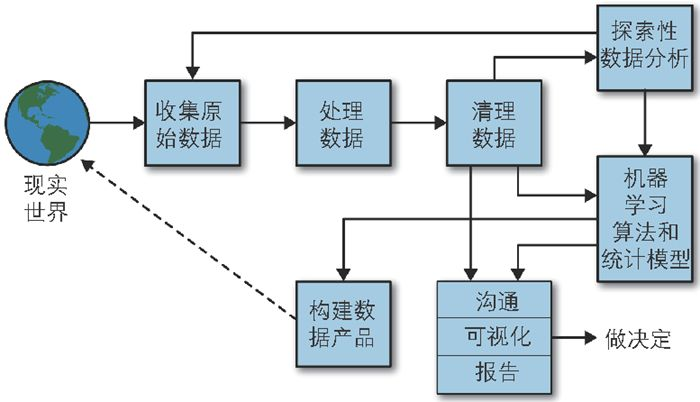

数据科学的工作流程

数据科学和统计学的不同:数据产品最终会融合到日常生活中,用户会和产品产生交互,交互会产生更多的数据,这样形成一个反馈的循环。在做任何分析时,都要将这种反馈考虑在内,以此对模型产生的偏差进行调整。模型不仅预测未来,它还在影响未来。